从第一个 Gemma 模型于去年年初推出以来,已逐渐发展为生机勃勃的 Gemmaverse 生态系统,累计下载量突破 1.6 亿。这个生态系统包括十余款专业模型系列,涵盖从安全防护到医疗应用的各领域。其中,最令人振奋的是来自社区的无数创新。从像 Roboflow 这样的创新者构建的企业级计算机视觉,到东京科学研究所创建的高性能日语 Gemma 变体,各位的作品为我们指明了未来的发展路径。

乘此发展势头,我们宣布 Gemma 3n 现已全面发布。虽然预览版已先行展示了一些功能,但这一移动设备优先的架构现在能够发挥出全部的潜能。Gemma 3n 为帮助塑造了 Gemma 的开发者社区而生。包括 Hugging Face Transformers、llama.cpp、Google AI Edge、Ollama 和 MLX 在内,您熟悉和惯用的多种工具都支持该模型,让您能轻松针对特定的设备端应用进行微调和部署。本篇文章将以开发者视角深入探索,介绍 Gemma 3n 背后的一些创新,分享新的基准测试结果,并向您展示如何立即开始构建。

Gemma 3n 的新功能

Gemma 3n 代表了设备端 AI 的重大进步,为边缘设备带来了强大的多模态功能;过去,这些性能仅在去年基于云端的一些前沿模型中有所展现。

多模态设计:Gemma 3n 原生支持图像、音频、视频和文本输入以及文本输出。

针对设备端优化:Gemma 3n 模型的设计以效率为重点,基于有效参数提供两种尺寸:E2B 和 E4B。虽然其原始参数数量分别为 5B 和 8B,但凭借架构创新,它们能够以媲美传统 2B 和 4B 模型的内存占用运行,E2B 仅需 2GB 内存、E4B 仅需 3GB 内存即可运行。

突破性架构:Gemma 3n 的核心特征包括新颖的组件,如用于计算灵活性的 MatFormer 架构、用于内存效率的逐层嵌入(PLE)、用于架构效率的 LAuReL 和 AltUp,以及针对设备端用例优化的全新音频编码器和基于 MobileNet-v5 的视觉编码器。

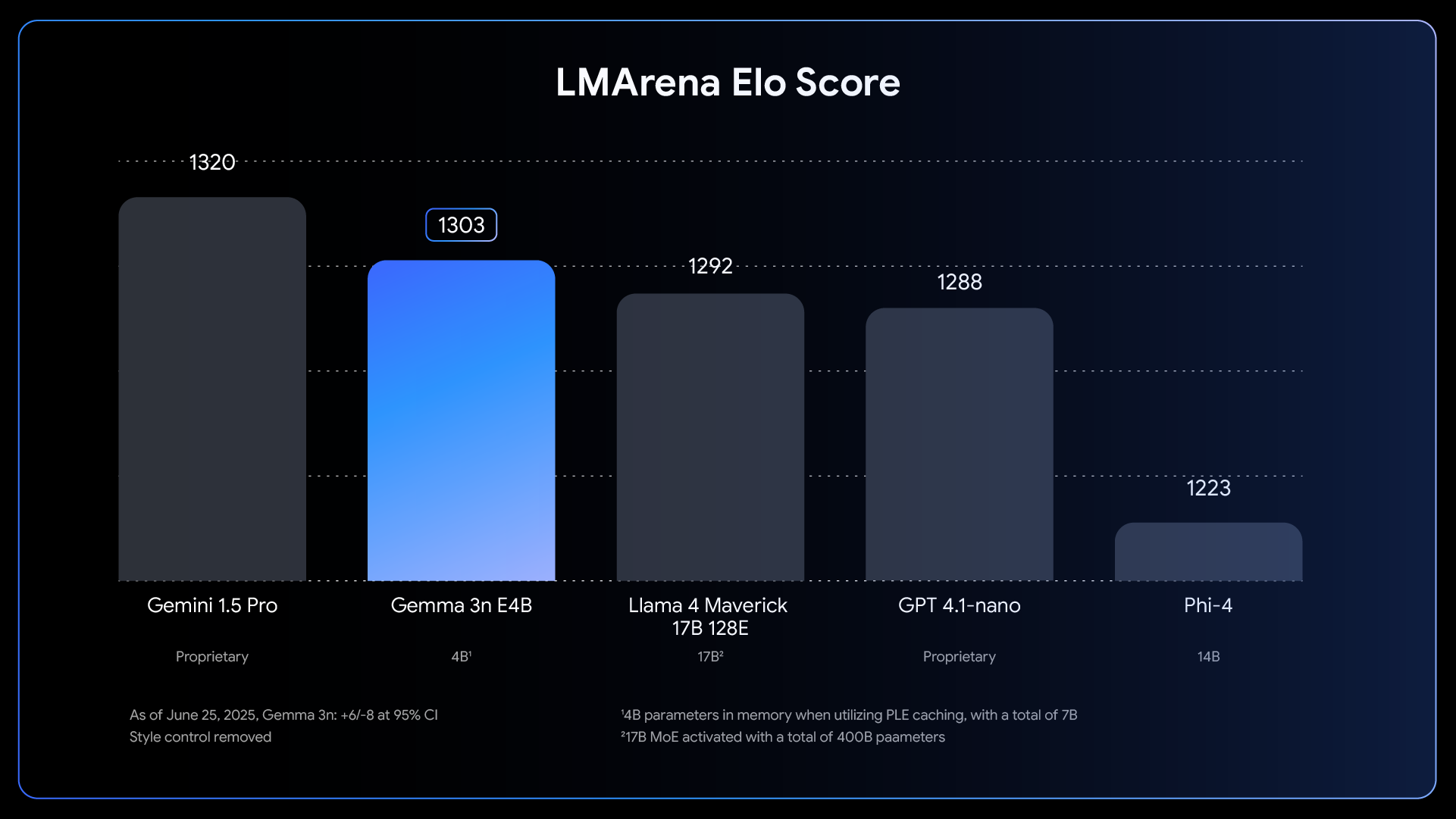

改进的质量:Gemma 3n 在多语言(支持 140 种语言的文本和 35 种语言的多模态理解)、数学、编码和推理方面的质量均有提升。E4B 版本的 LMArena 得分超过 1,300,是首个达到该基准且参数低于 100 亿的模型。

要实现这种设备端性能的飞跃,需要从零开始,对模型进行颠覆性的重新构思和设计,其基础是 Gemma 3n 独特的移动设备优先架构,而这一切都源于 MatFormer。

MatFormer:一个模型,多种尺寸

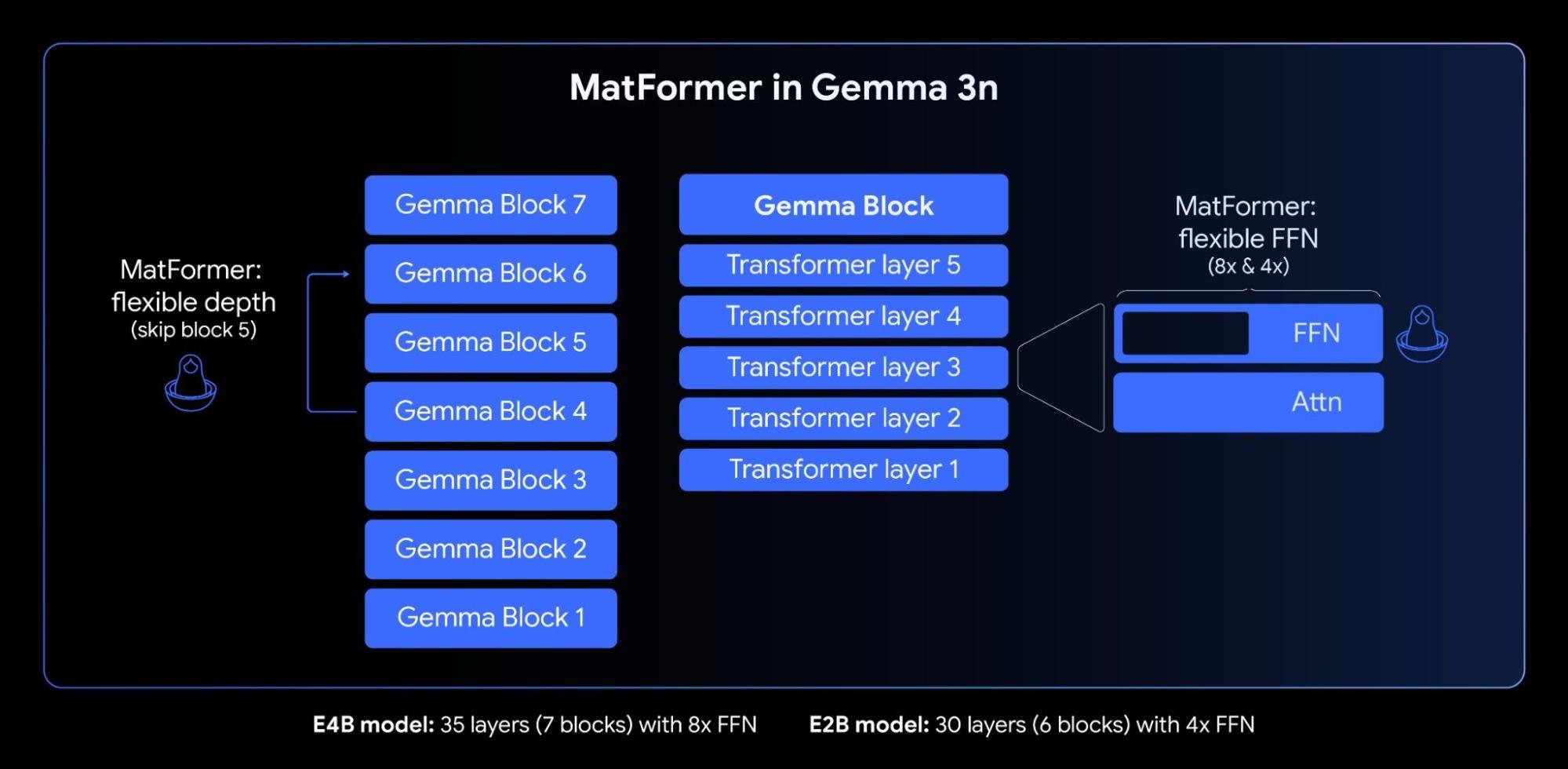

Gemma 3n 的核心是 MatFormer (Matryoshka Transformer)架构,这是一种专为弹性推理而构建的新型嵌套式 Transformer。您可以把它想象成俄罗斯套娃:一个更大的模型包含着更小、功能齐全的自身版本。这种方法将 Matryoshka 表征学习的概念从嵌入层扩展到所有 Transformer 组件。

如上图所示,在对 4B 有效参数(E4B)模型进行 MatFormer 训练期间,2B 有效参数(E2B)子模型在其内部同时得到优化。这在当下为开发者提供了两种强大的功能和用例:

预提取的模型:您可以直接下载并使用主 E4B 模型以获得最高级的功能,也可以使用我们已经为您提取的独立 E2B 子模型,获得主模型 2 倍的推理速度。

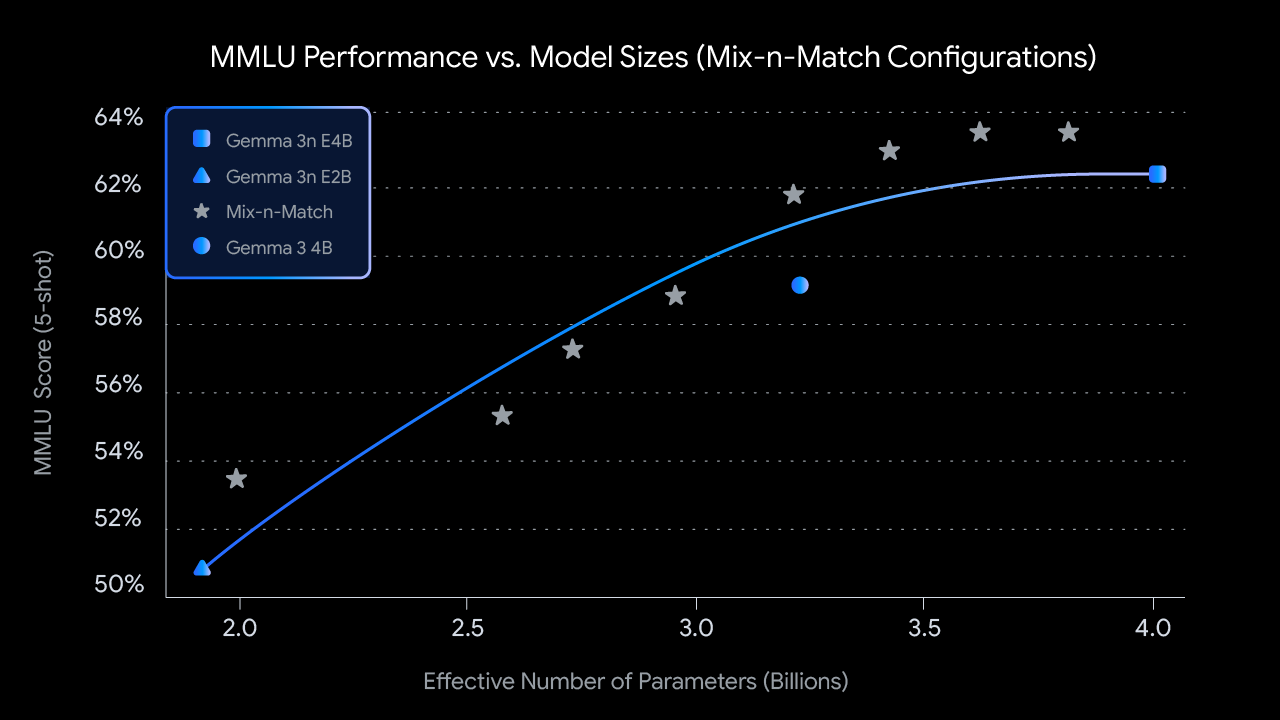

使用混合匹配(Mix-n-Match)自定义调整尺寸:为了更精细地控制以适应特定的硬件限制,您可以使用我们称之为 "混合匹配" 的方法,创建介于 E2B 和 E4B 之间的各种自定义尺寸模型。此技术允许您精确切分 E4B 模型的参数,主要是通过调整每层前馈网络隐藏维度(从 8,192 到 16,384)并选择性地跳过某些层来实现。我们即将发布 MatFormer Lab,该工具可演示如何检索这些最优模型,这些模型是在 MMLU 等基准测试中通过评估多种配置组合而筛选出来的。

展望未来,MatFormer 架构也为弹性执行铺平了道路。虽然这项能力并非本次发布实现的一部分,但它允许单个部署的 E4B 模型在 E4B 和 E2B 推理路径之间动态切换,从而根据当前任务和设备负载,实时优化性能和内存用量。

逐层嵌入(PLE):解锁更高的内存效率

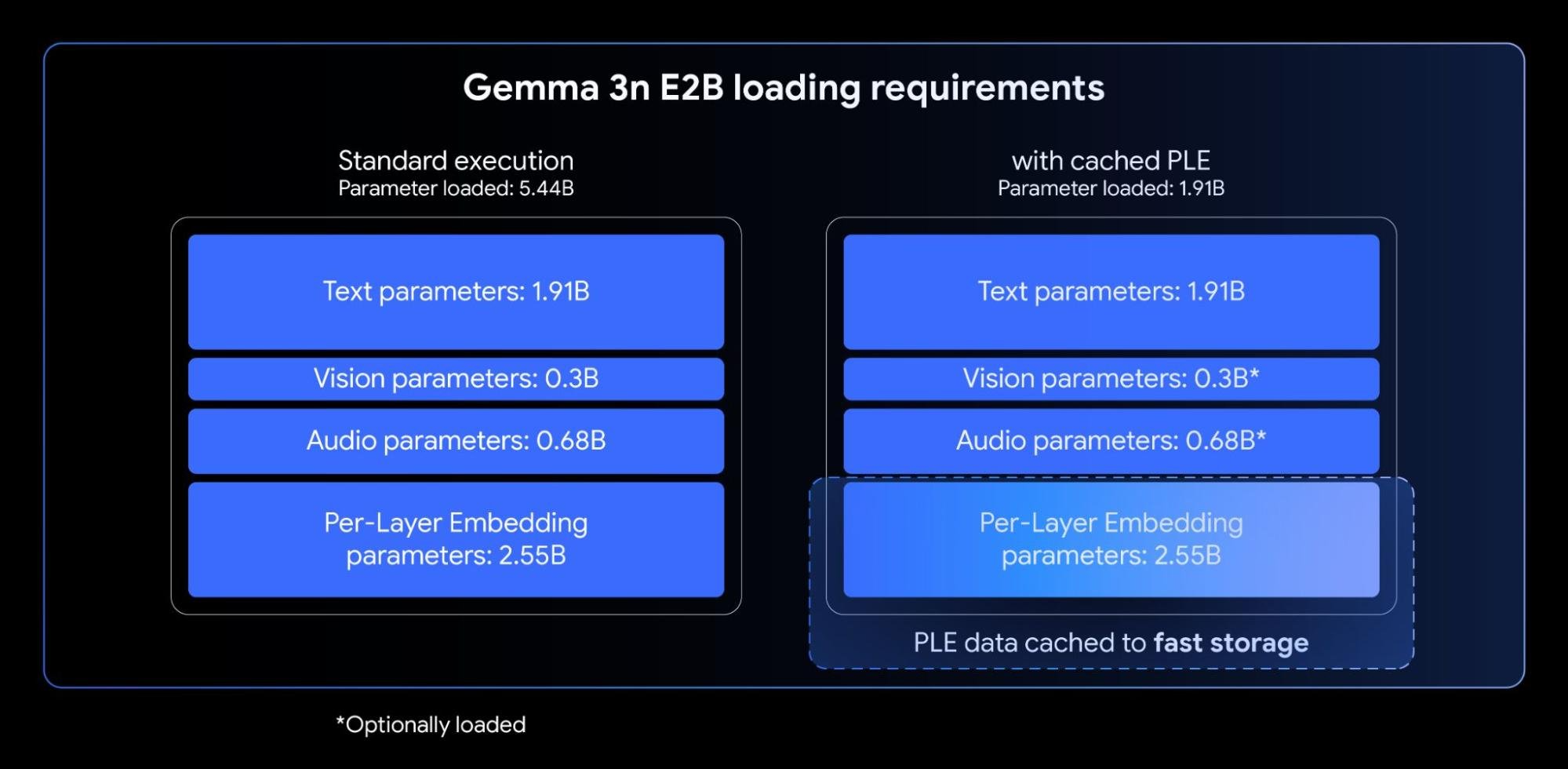

Gemma 3n 模型包含逐层嵌入(PLE)。这项创新专为设备端部署量身定制,它在不增加设备加速器(GPU/TPU)所需的高速内存占用量的情况下,显著提升了模型质量。

虽然 Gemma 3n E2B 和 E4B 模型的总参数量分别为 5B 和 8B,但逐层嵌入(PLE)技术却能让这些参数中的很大一部分(即与各层相关的嵌入),在 CPU 上高效地加载和计算。这意味着通常在更为受限的加速器内存(VRAM)中,只需加载核心 Transformer 权重(E2B 约为 2B,E4B 约为 4B)。

使用逐层嵌入,您可以在加速器中仅加载约 2B 参数的情况下使用 Gemma 3n E2B

KV 缓存共享:更迅速的长上下文处理

对于诸多先进的设备端多模态应用而言,处理长输入(例如源自音频和视频流的连续序列)至关重要。Gemma 3n 引入了 KV 缓存共享功能,旨在极大缩短流式响应应用的首个 token 生成时间。

KV 缓存共享优化了模型处理初始输入阶段通(常称为 "预填充" 阶段)的方式。将局部注意力和全局注意力中间层的键(Keys)和值(Values)直接与所有顶层共享,与 Gemma 3 4B 相比,预填充性能显著提升了 2 倍。这意味着该模型可以比以前更快地注入和理解冗长的提示序列。

音频理解:语音转文本和翻译功能

Gemma 3n 使用基于通用语音模型(USM) 的高级音频编码器。编码器为每 160ms 的音频生成一个 token(约每秒 6 个 tokens),然后将其作为输入集成到语言模型中,从而为模型提供高度精细的声音上下文表征。

这种集成的音频功能解锁了设备端开发的多种关键特性,包括:

自动语音识别(ASR):直接在设备端实现高质量的语音转文字。

自动语音翻译(AST):将口语翻译成另一种语言的文本。

我们观察到,对于英语和西班牙语、法语、意大利语及葡萄牙语之间的翻译,AST 的表现尤为出色,为针对这些语言的应用开发者提供了巨大潜力。对于语音翻译等任务,利用思维链提示可以显著改进结果。以下是一个示例:

<bos><start_of_turn>user Transcribe the following speech segment in Spanish, then translate it into English: <start_of_audio><end_of_turn> <start_of_turn>model |

截至文章发布时,Gemma 3n 编码器可处理长达 30 秒的音频片段。然而,这并不是一个根本上的限制。底层的音频编码器是一种流式编码器,通过额外的长篇格式音频训练,编码器可以处理任意长度的音频。后续实现将解锁延迟更低、时间更长的流媒体应用。

MobileNet-V5:最先进的全新视觉编码器

除了集成的音频功能外,Gemma 3n 还配备了全新的高效视觉编码器 MobileNet-V5-300M,可为边缘设备上的多模态任务提供最先进的性能。

MobileNet-V5 旨在为受限的硬件赋予灵活性和强大功能,为开发者提供:

支持多种输入分辨率:原生支持 256x256、512x512 和 768x768 像素的分辨率,让您可以根据特定应用需求平衡性能和细节。

广泛的视觉理解力:该功能采用海量的多模态数据集协同训练,擅长各种图像和视频理解任务。

高吞吐量:在 Google Pixel 上每秒处理帧数高达 60 帧,实现设备端实时视频分析和交互式体验。

这种性能水平是通过多项架构创新实现的,包括:

MobileNet-V4 模块的先进基础(包括通用倒置瓶颈和移动 MQA)。

显著扩展的架构,采用混合深度金字塔模型,其规模是最大的 MobileNet-V4 变体的 10 倍。

一种新型的多尺度融合 VLM 适配器,可优化 token 质量,以提高准确性和效率。

得益于新颖的架构设计和先进的蒸馏技术,MobileNet-V5-300M 在 Gemma 3 中的性能大大优于基准 SoViT(使用 SigLip 训练,无蒸馏)。在 Google Pixel Edge TPU 上,该编码器在有量化情况下提速 13 倍(无量化时为 6.5 倍),所需参数减少 46%,内存占用减少为原来的 1/4,同时在视觉-语言任务上的准确性显著提升。

我们很期待与大家分享该模型的更多研发工作,后续即将发布的 MobileNet-V5 技术报告将深入探讨模型架构、数据扩展策略和先进的蒸馏技术。

与社区共建

我们始终将 Gemma 3n 的易用性放在首位,也非常荣幸能与众多杰出的开源开发者合作,确保模型能在多个热门工具和平台得到广泛支持,其中包括来自 AMD、Axolotl、Docker、Hugging Face、llama.cpp、LMStudio、MLX、NVIDIA、Ollama、RedHat、SGLang、Unsloth 和 vLLM 等团队的贡献。

这个生态系统仅仅是开始,这项技术的真正价值在于用它构建的成果。正因如此,我们推出了 "Gemma 3n 挑战赛",使用 Gemma 3n 独特的 On-Device、离线和多模态能力,打造一款造福世界的产品。即刻参与挑战赛,提交引人注目的视频介绍,并通过精妙的演示展现产品的现实影响力,就有机会赢取 15 万美元的奖金和精美礼品!欢迎加入挑战,共创美好未来。

开始使用 Gemma 3n

准备好即刻探索 Gemma 3n 的潜力了吗?请查收以下攻略:

直接体验:只需点击几下,即可使用 Google AI Studio 试用 Gemma 3n。Gemma 模型也可以直接从 AI Studio 部署到 Cloud Run。

下载模型:在 Hugging Face 和 Kaggle 上查找模型权重。

学习&集成:深入了解我们的综合文档,快速将 Gemma 集成到您的项目中,或从我们的推理和微调指南开始入门。

使用您青睐的设备端 AI 工具构建,包括 Google AI Edge Gallery/LiteRT-LLM、Ollama、MLX、llama.cpp、Docker 和 transformers.js 等。

使用您喜爱的开发工具:利用您偏好的工具和框架,包括 Hugging Face Transformers 和 TRL、NVIDIA NeMo Framework、Unsloth 和 LMStudio。

随心部署:Gemma 3n 提供多种部署选项,包括 Google GenAI API、Vertex AI、SGLang、vLLM 和 NVIDIA API Catalog。

我们还准备了详尽的视频教程,帮助您更轻松、快速地上手 Gemma,欢迎您查看 Bilibili 视频合集——Gemma 3:从入门到精通,探索更多精彩内容!

文章信息

相关推荐

精选内容

微信公众号